**イラスト付きトランスフォーマー**

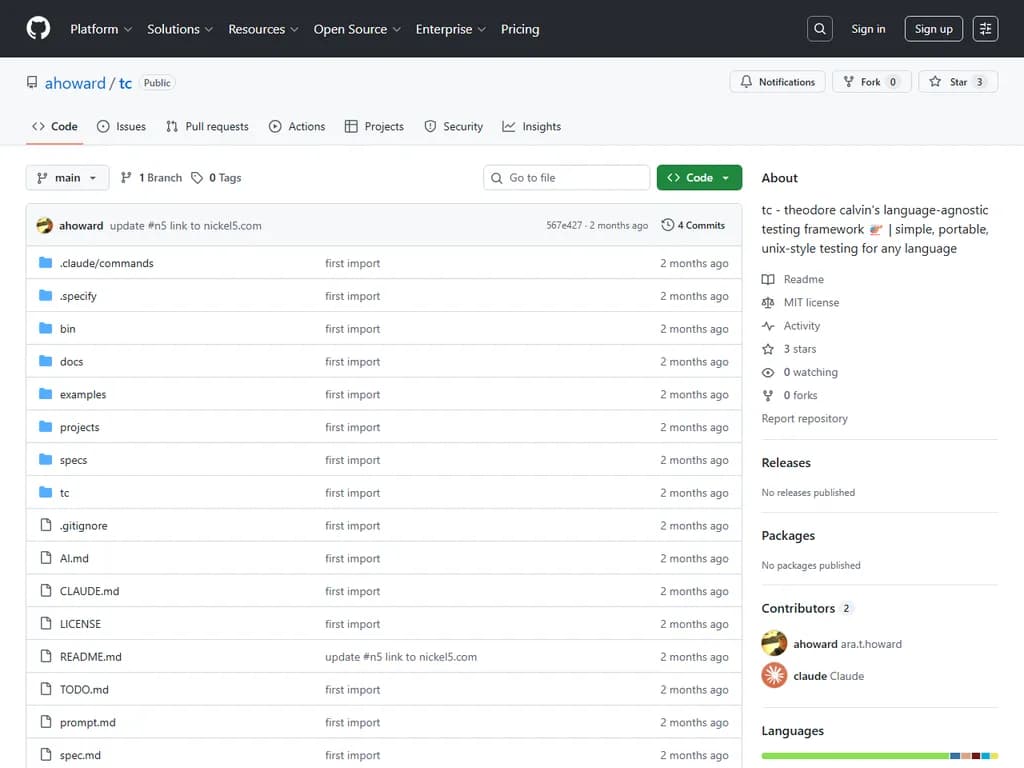

## Japanese Translation: 記事は「Attention is All You Need」で紹介されたTransformerアーキテクチャと、従来の再帰型や畳み込み型ニューラル機械翻訳モデルに比べてその注意力ベース設計がトレーニングを高速化する方法について説明しています。 Transformerはエンコーダスタック(通常6層)とデコーダスタック(同じく6層)で構成されます。各層には以下の要素があります: 1. **自己注意**では、トークン埋め込み(512次元ベクトル)がクエリ・キー・バリュー行列にそれぞれ64次元へ射影されます。ドット積スコアは \(\sqrt{64}\) で縮小し、softmax を適用して値を重み付けし、合計します。 2. **マルチヘッド注意**では、各層に8セットの Q/K/V 射影が使用されます。すべてのヘッドからの出力は連結され、最終的な重み行列 \(W_O\) を通じて射影されます。 3. フィードフォワードニューラルネットワーク(ReLU の間にある2つの線形層)。 すべてのサブレイヤは残差接続とその後のレイヤ正規化で包まれています。 位置エンコーディング(512次元の正弦/余弦ベクトル)は埋め込みに加算され、モデルがトークン順序を知り、訓練時より長いシーケンスを扱えるようにします。デコーダでは自己注意がマスクされ、将来位置は \(-\infty\) に設定されるため、オートレグレッシブ生成が保証されます。 最終的なデコーダ出力は線形射影されてロジットベクトル(次元はターゲット語彙サイズ ≈10 000 単語)となり、その後 softmax で単語確率を得ます。訓練では、これらの分布とワンホットエンコードされた目標トークン間のクロスエントロピー損失が最小化され、逆伝播により最適化されます。 デコーディングは貪欲法またはビームサーチで行うことができ、記事では将来的にデコーディング戦略と大規模語彙や長いシーケンスへの訓練を改善する予定だと述べています。本文は元論文、Tensor2Tensor コード、Jupyter ノートブック、および後続のTransformerバリアントを参照し、Twitter での訂正を歓迎しています。 産業界において、Transformers を採用すると NLP プロジェクトが加速し、翻訳品質が向上し、言語集約型サービスへの展開が拡大します。