2026-01-23

日付別ニュース一覧

カードをクリックすると全文、Hacker Newsのリンクから元記事へ移動できます。

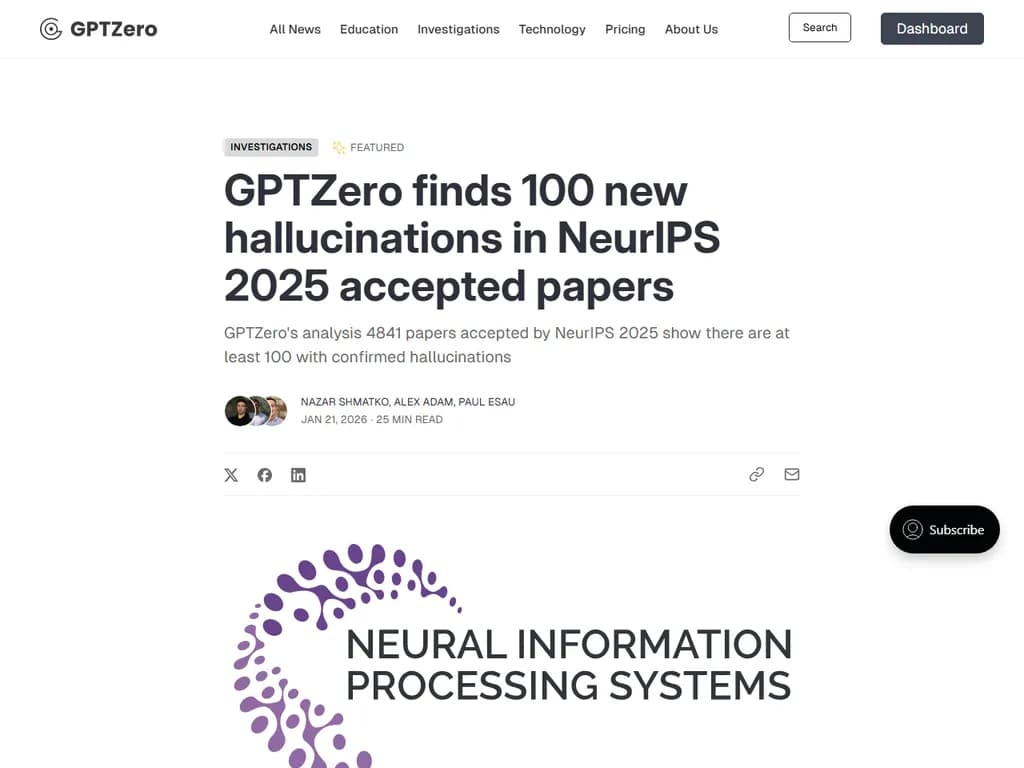

**Scheme を WebAssembly にコンパイル**

## Japanese Translation: --- ## Summary Pythonで実装されたオープンソースScheme実装「Bob」は、15周年を記念してネイティブWASMバイナリを生成するWebAssembly(WASM)コンパイラを追加しました。新しい `WasmCompiler` は解析済みのScheme式を直接WASMテキストに変換し、その後 wasm‑tools スイートでコンパイルされ、Node.js経由で実行されます。 コンパイラの核心は、Schemeプリミティブを実装する約1,000行のWASMコードから成ります: - **オブジェクト表現** – SchemeオブジェクトはWASM GC型にマッピングされます: - `$PAIR` 構造体は `car` と `cdr` を `(ref null eq)` 参照として保持します。 - `$BOOL` 構造体は単一の `i32`(0 = false、非ゼロ = true)を保持します。 - `$SYMBOL` 構造体は線形メモリ内でオフセットと長さを表す2つの `i32` を保存します。 - **数値** – 整数値は `i31` 型を使用してボックス化されていない整数を直接参照します。 - **シンボル** – シンボルは線形メモリに固定オフセット(例: `(data (i32.const 2048) "foo")`)で発行され、アドレス/長さペアで参照されます。 - **組み込み関数** – `write` 関数はWASMテキスト内で直接実装され、ホスト関数として `write_char` と `write_i32` の2つだけをインポートします。 Bobはすでにインタープリタ、コンパイラ、VM、およびカスタムマーク・アンド・スウィープGCを備えたC++ VMを提供しています。追加されたコンパイラは今後さらに進化する予定ですが、現在のwasmtime用Pythonバインディングは2023年10月に仕様に組み込まれたWASM GC提案をまだサポートしていないため、SchemeをWebAssembly上で完全にガベージコレクション実行することが制限されています。 それでもユーザーは今やSchemeを直接WebAssemblyとして実行できるようになり、クロスプラットフォームのデプロイメントとJavaScript/Node.js環境とのより緊密な統合の可能性が開かれます。

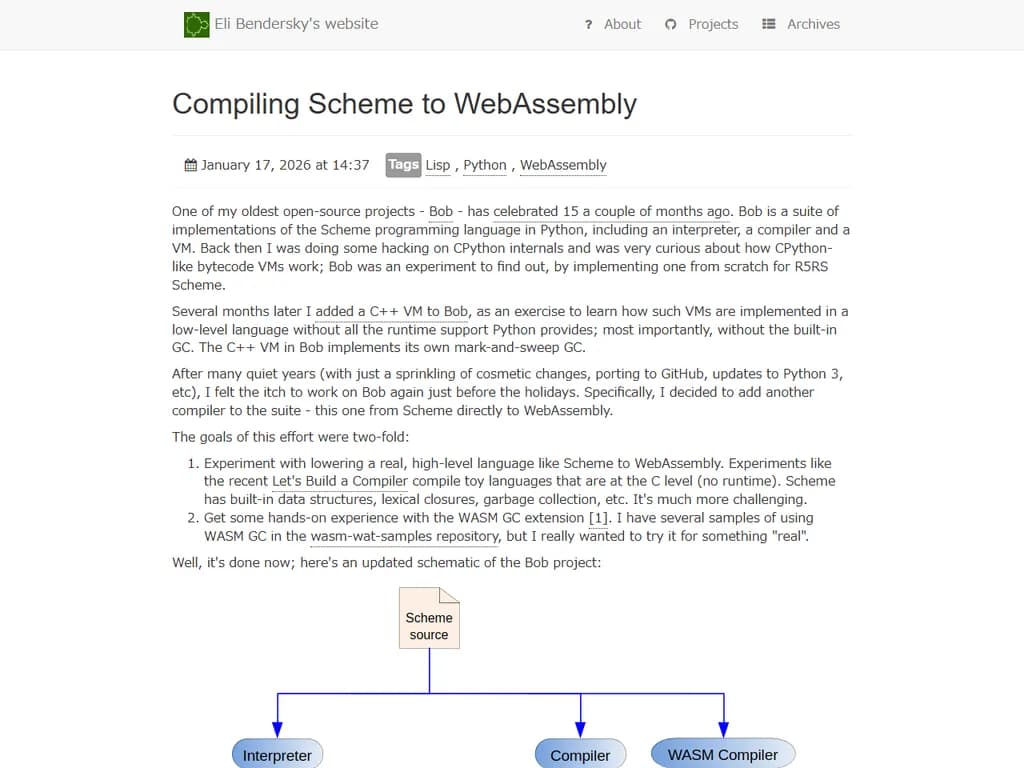

**CSS の光学的錯覚**

## Japanese Translation: (すべての主要なポイントを統合したもの) > 記事は、マウスホバーに応じて反応するインタラクティブな CSS ベースの錯視デモの CodePen ギャラリーを提示しています。 > 各デモは、Poggendorff の歪んだ線(傾いた 2 つのグラデーションと `::before`/`::after` を使用)、誘導グラデーション効果、Cornsweet & White の色コントラストトリック(黒白格子に `mix-blend-mode` を適用)、リングおよびチェッカーボードパターン、重なり合う線の色球体、曲率盲点、Café Wall イルлю(3 本のグラデーションで平行線を斜めにする)、ペノース三角形やエビングハウス円、カニッツァ四角形など、古典的な視覚現象を示しています。 > ギャラリーには、エビングハウス錯視のアニメーション版、回転する「タワー」、色のファン、逆スピーク、モーションバインディング、メンツラインズ、ウォッリングカラーなども含まれ、ドット線の動きやコントラスト非同期、息を吸う四角形、トロックラー消失といった静的に動きを示唆するパターンも掲載されています。 > すべての効果は CSS グラデーション、疑似要素、`mix-blend-mode`、およびキーフレームアニメーションで実現され、微妙な背景やホバー変更がどれほど印象的な視覚トリックを生み出せるかを示しています。 > コレクションは Patrick Pester の「35 optical…」リストと Michael Bach の「154 Visual Phenomena & Optical Illusions」に触発されています。 > Medium と DEV に公開されており、著者は将来の追加や改良の可能性について読者にコメントを残すよう呼びかけています。 *この改訂された要約は、すべての主要なポイントを完全に反映し、推測を加えず、明確で簡潔に保っています。*

**アクティブ・シッティングは脳健康に有益:研究レビュー**

## 日本語訳: **要約** 最近の研究では、座り方が脳の健康に影響することが示されています。85件の研究を系統的にレビューした結果、**精神的に活動的な座位**(読書や戦略ゲームへの参加、会話など)は実行機能と記憶力を向上させる一方で、**受動的な座位**(例:テレビ視聴)は認知機能の低下および認知症リスクの増加に関連していることがわかりました。クイーンズランド大学のポール・ガーディナーを筆頭とする著者らは、正式な脳トレーニングプログラムではなく、日常的な座位行動を検討しました。その結果、公衆衛生指針は受動的座位と活動的座位を区別し、人々が座ったままの時間に精神刺激的なタスクを取り入れ、短い休憩で身体を動かすよう奨励すべきだと示唆しています。この変化は個人の選択(受動メディアより本やインタラクティブゲームを好む)に影響し、保健機関からの新しいガイドラインを形成し、家具・エンターテイメントデバイス・職場環境の設計者が活動的座位習慣を促進するよう促す可能性があります。また、認知的幸福感に対する微細な推奨事項についてさらに研究が進むことも期待されます。

**ファーストイヤー体験** * テクノロジー創業者として営業に挑んだ最初の一年。

## 日本語訳: (以下に翻訳したテキストを記載します) ## Summary 著者は、ブートストラップ型のSaaSスタートアップが自己サービスマーケティングよりもハイタッチなセールスプロセスを優先すべきだと主張しています。マーケティングからIbex(エージェンシー/ SaaS ハイブリッド)の創業へ移行した後、彼らはLinkedInとコールドメールアウトリーチを活用しています—30日間で487件の接続リクエストが送信され、175件が承諾され、43件に返信があり、15件が関心を示し、11件がデスカバリー・コールを予約(うち8件が実施)、4件が契約に署名、4件がオンボーディングされ、最終的に2件が有料クライアントとなりました。セールスファネルは、重いセットアップとAIコストを投資する前に真剣な見込み客をフィルタリングするための二ページ構成のパイロット契約でゲートされています。 コールは事前承認済みのカレンダーを通じてスケジュールされ、やり取りを減らします。著者は、コール後の要約にAIトランスクリプションよりも手書きメモを好んでいます。このプロセス—複数回のビデオコール、コピーライティング、自動化、およびAIエージェント設定—は「ソリューションズエンジニアリング」と表現されており、信頼構築と有料コンバージョンへ導きます。セールスはまた実世界のフィードバックループとして機能します:拒否は個人的な侮辱ではなくデータとして扱われ、迅速なビジネス最適化を可能にします。 著者はオファーとセグメントに対して毎月A/Bテストを実施し、理想的顧客プロファイル(ICP)を洗練させています。ICPはまだ確定途中であることを認めています。リード生成はスケーラビリティのためにコールドメールを利用しますが、LinkedInの高い意図を持つ連絡先から恩恵を受けます。読者には質問や協力についてメールで連絡するよう招待し、このモデルを採用すると顧客単価を上げ、関係性を強化し、他のSaaS企業がマーケティングとセールスのバランスを取る際にプロダクト・マーケットフィットを情報提供するフィードバックループを作成できると述べています

**デンマーク・ヴァイキング船博物館、最大規模のコグを発見** デンマークにあるヴァイキング船博物館は、史上最大のコグ(船底部の構造)を発見したと発表しました。この重要な考古学的発見は、中世の船舶建造技術や海運貿易について新たな洞察を提供します。

## Japanese Translation: ## 要約 Svælget 2(オーレスンド最大の中世コグ船)の発見は、後期中世の造船技術・貿易ネットワーク・海上の日常生活を知るためのユニークな窓を提供します。1410年頃に建造されたこの船は、長さ約28 m、幅9 m、高さ6 mで、貨物容量は約300 tです。その構築は複雑なサプライチェーンを示しており、オーク板はポーケニアから供給され、枠組みはオランダから調達され、木造の舷尾城(「キャッスル」と呼ばれるもの)は初めて考古学的に証明された構造です。また、約200枚のレンガと15枚のタイル、銅製ポットで構成されるレンガ船体は、デンマーク水域で発見された最も古い例です。 海面下13 mで発見されたこの船は、右舷側が砂に保護されていたため優れた保存状態を示し、航海用ロープや帆の制御、桅木の支柱、貨物安全に関する前例のない洞察を得ることができました。塗装された木製皿、靴、櫛、念珠ビーズ、調理器具、株魚棒などの個人用品も回収され、乗組員の日常生活を示しています。貨物自体は直接残っておらず、バランス材がないことから、沈没後に浮き上がった可能性のある大量の貿易品で船舶が積み込まれていたと考えられます。 Svælget 2は、以前の小型コグ船と後期オランダ商船との間のギャップを埋め、中世における高度に組織化された貿易システムを浮き彫りにしています。このシステムは、塩、木材、レンガ、食料品などの大型貨物を北欧全域で輸送することができました。デンマーク国立博物館のブレデワークスで保存作業が進められており、フォトグラメトリーによるデジタル再構築も行われています。この船の貨物積載パターンと建造技術をさらに研究することで、中世海上物流と船舶技術の進化に関する理解が深まるでしょう。

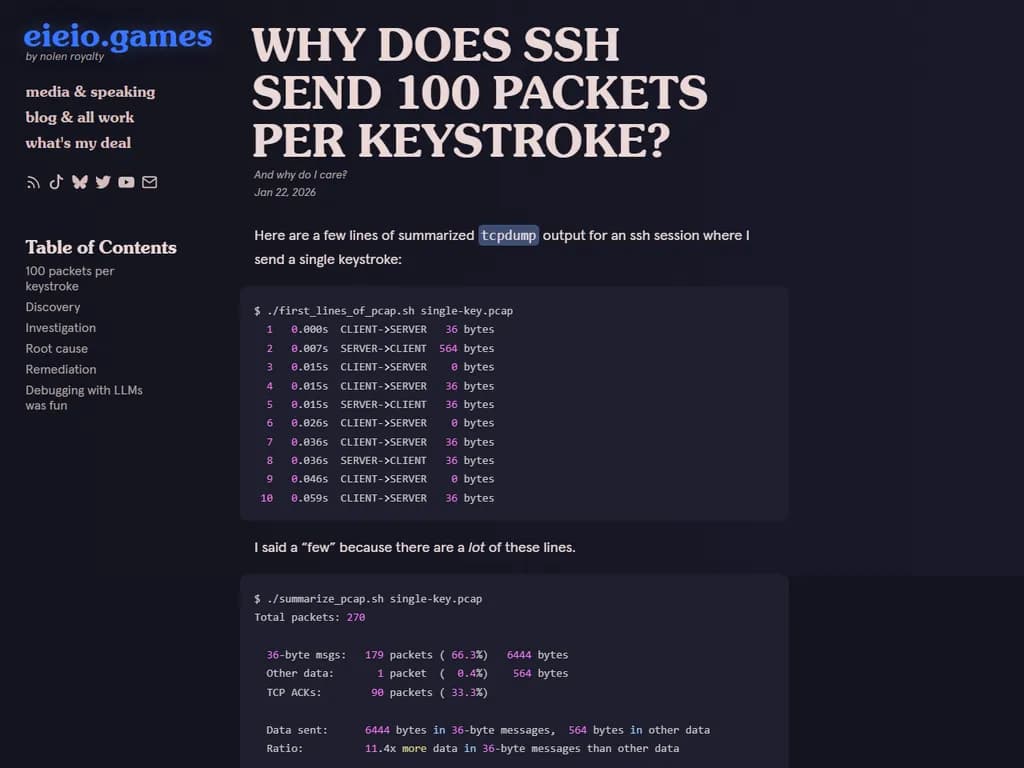

SSH は実際には「1 回のキー入力につき 100 パケットを送る」わけではありません。送信されるパケット数は、SSH プロトコル設計とネットワーク状況に応じて決まります。 --- ## 「1 キーストローク=100 パケット」に見える理由 | # | 原因 | 説明 | |---|------|------| | 1 | **パケットの分割(フラグメンテーション)** | SSH のトランスポート層はデータを固定長ブロック(既定では 64 KiB)に分割します。<br>キー入力で生成される数バイトがそのブロックサイズまでパディングされ、1 パケットとして送信されます。 | | 2 | **暗号化オーバーヘッド** | 各パケットには暗号ヘッダー・MAC(メッセージ認証コード)が付加され、場合によっては圧縮ヘッダーも含まれます。<br>これらの余分なデータが「実際に送信された」パケット数を増やすように見える原因となります。 | | 3 | **ネットワークフラグメンテーション(MTU)** | 大きい SSH パケットは、ネットワークスタックによって MTU サイズ(約 1500 バイト)ごとに分割されます。<br>1 本の SSH パケットが複数の IP フラグメントへ変換され、各フラグメントが「別個のパケット」として計測されることがあります。 | | 4 | **TCP ウィンドウと再送** | 小さなパケットは高いレイテンシ環境では ACK(確認応答)や再送を頻繁に発生させ、観測上のパケット数が増加します。 | | 5 | **サーバ側バッファリング** | サーバは複数のキー入力をまとめて送信する前にバッファリングし、その後いくつかのパケットに分割して転送することがあります。 | --- ## 結論 「1 キーストローク=100 パケット」という誤解は、SSH のブロックベース設計、暗号化オーバーヘッド、MTU によるフラグメンテーション、およびネットワーク挙動の組み合わせによって生じます。プロトコル自体が意図的にリンクを詰め込むわけではありません。

## Japanese Translation: 著者のSSHベースのTUIゲーム(bubbletea + wish)は約2 000人の同時プレイヤーを想定して設計されましたが、予期せぬ高CPUと帯域幅使用量に悩まされました。「your screen is too small」というテストハーネスはリソース使用量を約50%削減しました。ポート 22でのパケットキャプチャでは約413 kパケットが確認され、274 k(66 %)が36バイトのチューブ、139 k(34 %)がゼロバイトACK、数個の72バイトパケットでした。この36バイトメッセージは単一キー入力SSHセッションでも約20 msごとに現れました。 `ssh -vvv` で確認したところ、OpenSSH の「obfuscate_keystroke_timing」拡張(2023年追加)が SSH2_MSG_PING を介してタイピングタイミングをマスクするためにこれらのチューブパケットを送信しています。クライアント側でこの機能を無効化 (`ObscureKeystrokeTiming=no`) すると、CPU と帯域幅はほぼ半分に削減されますが、ユーザー設定が必要です。 サーバー側のオーバーヘッドを除去するため、著者は `golang.org/x/crypto/ssh` をフォークし、 `[email protected]` 拡張(ピン/ポンコード)を宣言していたコミットをロールバックし、依存関係を置き換えました。これにより総CPU使用率が約30 %から11.6 %、システムコール時間が3.1 秒から0.66 秒へ、暗号処理時間が1.6 秒から0.11 秒へ、帯域幅が6.5 Mbit/sから約3 Mbit/sに減少し、高同時接続SSHゲームの性能向上に大きく貢献しました。 著者はまた、LLMs(Claude Code)がデバッグを支援したものの、人間による監督がパッチを特定し適用するために不可欠であると指摘しています。将来的にはよりターゲットを絞った最適化が検討されるかもしれませんが、現在の修正はリソース集約型TUIアプリケーションユーザーのスケーラビリティとレイテンシを既に改善しています。

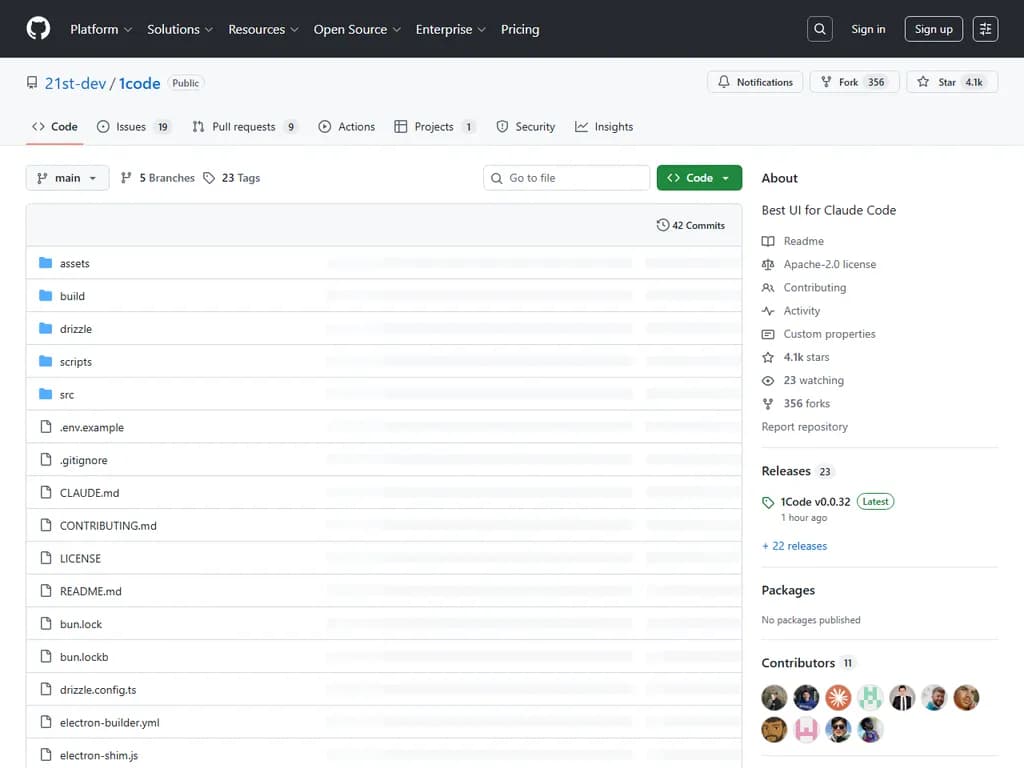

**HN Show:** 「Ollama ローカルモデル向け最初の Claude Code クライアント」

## Japanese Translation: ## 要約 1Code はクロスプラットフォームのデスクトップアプリで、開発者に Claude Code のビジュアル UI を提供し、クラウド同期なしでローカル優先のコード編集と Git ワークフロー管理を可能にします。 主な機能は次の通りです: * **Git worktree 分離** – 各チャットが独自の isolated worktree で実行され、ブランチ安全性により main への誤コミットを防止します。 * 複数エージェントのバックグラウンド実行と専用 **agent mode**(読み取り専用分析 vs 完全コード実行権限)。 * ビジュアルステージング、コミット、ブランチを提供する組み込み Git クライアント、および完全なコマンドラインアクセスが可能な統合ターミナル。 * Claude が行っている変更をリアルタイムで差分プレビューし、変更追跡と PR 管理を実現します。 * AI 実行をステップバイステップの計画に構造化する **Plan mode**、クリーンな Markdown プレビュー、実行前のレビューが可能です。 * 自動 Git リモート検出、カスタムサブエージェント、および plan/agent モード切替を含むプロジェクトレベルのサポート。 Windows バージョンはコミュニティ貢献者 @jesus-mgtc と @evgyur により改善されました。ユーザーは Bun/Python/Xcode ツールを使用してソースからインストールするか、**1code.dev** を購読してバックグラウンドエージェントサポート付きの事前構築リリースを入手できます。Claude CLI バイナリを取得するために必須の `claude:download` ステップが必要であり、スキップするとエージェント機能は無効になります。 購読モデルは継続的な保守、機能開発、および Discord を通じたコミュニティ関与を資金提供します。今後のアップデートではエージェント機能の拡張、plan/agent モードの洗練、そしてローカル優先ワークフローのさらなる向上が期待されます。 Claude の AI を活用しつつコード編集をローカルに保つことで、1Code は知的財産を守る安全で Git 互換なワークフローを提供します。その Apache 2.0 オープンソースライセンスは個人や組織からの広範な採用と貢献を奨励しています。

**Tree‑sitter 対 言語サーバー**

## Japanese Translation: **概要:** Tree‑sitter と Language Server Protocol(LSP)は、モダンなコードエディタにとって相補的なツールです。Tree‑sitter はソースファイルを高速かつ許容的に解析し、正確な言語要素を抽出するためにクエリ可能な構文木を生成します―これが高速で正確なシンタックスハイライトに最適です。一方 LSP はエディタと各プログラミング言語ごとの単一サーバー間の JSON ベースの通信チャネルを定義し、定義検索・オートコンプリート・診断・セマンティックトークン(可変性などの情報を含むハイライト)といった機能を可能にします。Emacs の Eglot は現在 LSP ベースのセマンティックハイライト(`eglot-semantic-tokens-mode`)をサポートしており、Rust の `rust-analyzer` などはこれらのトークンを使用して可変性を表示します。Tree‑sitter は依然として構文描画のデフォルトであり続けますが、LSP は言語サーバーがより豊富なコンテキストやファイル横断的解析を提供できる場合に有用です。LSP が進化するにつれ、ハイライト品質で Tree‑sitter に匹敵または上回る可能性があり、エディタと開発者は複数の言語固有ツールを必要とせずに恩恵を受けられるでしょう。

**アンソロピック経済指数** *経済原始(プリミティブ)*

あなたのアプリのサブスクは、今や私の週末プロジェクトになっています。

## Japanese Translation: > 記事では、macOSやSwiftの経験がない人でも、著者自身の週末プロジェクトを利用して、安価な「機能アプリ」を迅速に構築できる方法について説明しています。具体的には **Jabber**(無料の Wispr‑Flow クローン)、**Reel**(カメラ移動とトリミング付き Loom スタイルのスクリーンレコーダー)、そして **Hugora**(Hugo ブログ用 Markdown エディター)です。各アプリは月額 30 ドル未満で運用できる一方、著者が Wispr‑Flow に 14 カナダドル/月、Loom に 15 ドル/月を支払っている有料サービスと同等の機能を提供します。 > 著者は、これら 10 ドル以上/月のサービスが「製品ではなく機能」であると指摘し、大規模なオファリングに簡単に組み込むことができると述べています。記事で引用された Medium の投稿は、独立した機能アプリへのシフトを予測しています。個人向けのオンデマンド作成には vibecoding が有効ですが、メンテナンス性の懸念から本番環境での展開には慎重な姿勢を保っています。 > 要するに、低コストで迅速に構築できる機能アプリは、プロトタイプやコンポーネントとして、将来的に開発者や企業がより広範な製品へ統合する可能性があります。

**Launch HN:Constellation Space(YC W26)** *人工衛星ミッション保証のためのAI*

## Japanese Translation: --- ## Summary Constellation Spaceは、90%以上の精度で衛星リンク障害を発生前3〜5分に予測するAI駆動型システムを構築し、急速に拡大する低軌道(LEO)衛星ファミリーに対して従来の遅延があり反応的なSNR閾値モニタリングを置き換えることを目指しています。 このソリューションは、宇宙船テレメトリ、地上局、気象レーダー、スペースウェザー監視装置、およびIoT湿度センサーなど多様な情報源から毎秒約**100 k件のメッセージ**を取り込みます。物理ベースのリンク予算計算(完全方程式、ITU大気標準、軌道伝搬)と数十億点にわたる複数軌道データで訓練された機械学習層を組み合わせています。フェデレーテッドラーニングにより各オペレーターはローカルモデルを訓練しながら、高レベルのパターンのみを共有でき、LEO Ka‑band、MEO、およびGEO運用間で転移学習が可能になり、生テレメトリを公開することなく実現します。 チームの過去の業績はStarlink(SpaceX)、Blue Origin の New Glenn、NASA の深宇宙通信に及びます。現在**10 k機衛星**を保有し、2030年までに**70 k機以上**が計画されているため、従来の反応型SNRアプローチはもはやスケーラブルではありません。 現時点でのテストパートナーには防衛および商業企業が含まれます。ダッシュボードはすでにリアルタイムリンクヘルス、**60 s、180 s、および300 s**の予測、根本原因分析を表示し、テレメトリ取り込み、予測、トポロジースナップショット、およびLLMチャットエンドポイント用APIも公開しています。残る課題は5分以上先までの精度向上、希少な極端ケースに対するラベル付き障害データの収集、およびオペレーター間のセキュリティ境界を越えたフェデレーテッドラーニングの調整です。 採用されれば、Ka‑band、MEO、およびGEOコンステレーションの運営者はスケーラブルなネットワークオペレーションセンター(NOC)を稼働させ、ダウンタイムを削減し、ミッション信頼性を向上させ、商業・政府ユーザー双方に対して安全でクラウド非依存のデプロイメントオプションから恩恵を受けることが可能になります。

**Lyftバイクを逆解析して楽しむ(お金になる?)**

## Japanese Translation: 記事では、ハッカーがアプリの「レンタル」APIリクエストを再送信することでLyftバイクを遠隔でロック解除できる方法を示しています。 iPhoneにCharles ProxyのルートCAをインストールしてトラフィックを捕捉し、レンタルエンドポイントを特定しました:`POST https://layer.bicyclesharing.net/mobile/v2/fgb/rent`。このリクエストにはヘッダー `api-key` と `authorization` が必要で、ボディにはユーザーの緯度/経度(`userLocation`)と、`memberId` および5桁のバイクIDを含むネストされた `qrCode` オブジェクトが入っています。 この情報をもとに著者はPythonスクリプトを作成し、10 000〜20 000 の範囲内のすべての 10,000 個のバイクIDを順番に試しながらレンタルリクエストを送信しました。単純な逐次ループでは約3時間かかりますが、非同期 `aiohttp` バージョンでは15秒程度(約650 RPS)でスキャン完了します。 Lyftは2019年にこの脆弱性を通知され、クライアント側の操作をブロックする予約機能を追加してパッチを適用したため、攻撃は無効化されました。著者はHackerOne経由でLyftから$500の報奨金を受け取りました。 この脆弱性は、おそらくFord GoBikes の元々のコードベースにおいて同時実行レンタルリクエストを正しく処理できないレースコンディションが原因と考えられます。このケースは、クライアント提供のGPSデータに頼るのではなく、より堅牢なサーバー側検証(例:厳格なジオフェンシングや追加チェック)が必要であることを示しています。

AnswerThis(YC F25)は採用活動中です。

## Japanese Translation: > **AnswerThis** は、科学的発見を加速するエンドツーエンドのワークスペースです。科学者向け「レコードシステム」として構築されており、研究者は論文検索・実験分析・原稿作成・ピアやAIエージェントとのコラボレーションをすべて一つのプラットフォームで行えます。2024年に Y Combinator の F25 バッチとしてローンチされ、8か月で **$1 M ARR** を達成し、**200 k+ 研究者**(スタンフォード大学、MIT、Amazon などのトップ機関を含む)にサービスを提供しており、**キャッシュフローロジティブ**、チームは6人で運営しています。 > 同社は Next.js、Prompt Engineering、Python マイクロサービス、AWS、およびベクトルデータベース・グラフ RAG・エージェントメモリを含む agentic AI スタックを使用して高速な結果を提供します。 > **採用情報**:AnswerThis はサンフランシスコ(リモート US も可ですが SF 外は不可)でのフルスタックエンジニアを募集しています。この役割では、規模に合わせて迅速にプロダクトを出すこと、agentic AI スタックへの深い知識、科学的発見を加速する情熱、および顧客と話す意欲が求められます。自身で研究成果を発表した経験があればボーナスがあります。 > 報酬は **$120K–$200K** で株式も付与されます。採用プロセスは、スクリーン + 技術面接、テイクホーム評価、最終電話、1週間の有給トライアルプロジェクト、そしてオファーという流れで、全て **2–3週間** 内に完了します。応募者は履歴書とともに AnswerThis の好き点・嫌い点、および自慢できるプロジェクトについてコメントを送付してください。 > **ミッション**:助成金申請や文献レビューに費やす時間を短縮することで、AnswerThis は研究者が発見により多くの時間を割けるようにし、学術界と産業界全体で科学的進歩を加速します。

**保存された魚、ニューヨーク市のボス**

## Japanese Translation: > Preserved Fish(1766年生まれ)は、著名なフィッシュ家系に属するニューヨークの起業家でした。彼のクエーカー族由来の名前は「罪から守られる」を意味します。彼は漁船乗りとしてキャリアを始め、その後鯨油を販売し、さらに広範な海運事業へと拡大しました。そのビジネスを離れた後、彼の会社はGrinnell, Minturn & Co.となりました。フィッシュは初期のニューヨーク証券取引所委員会に参加し、その後銀行長にも就任しました。1819年には一時的にTammany Hall(民主党機関)が統治するニューヨーク市を支配しました。この期間、彼は改革派のLocofocosから反対を受けました。Locofocosは自己点火マッチ(“locofoco”)を使ってTammanyのガス灯が消されたときにキャンドルを点灯し、政府銀行や紙幣に反対していました。「locofoco」という用語はラテン語の*focō*(火)と*loco‑*(誤って「自己」を意味すると解釈される)から組み合わさっています。彼は異名で知られながら、ビジネスと政治で顕著な成功を収めましたが、歴史書にはほとんど完全な章が設けられていません。

「2万台のGPUを健康的に維持する」

## 日本語訳: **改善された要約** Modal は、膨大でグローバルに分散したワーカー プールを厳格な自動化とヘルスモニタリングと組み合わせることで、市場で最も信頼性の高い GPU ベースのコンピュート プラットフォームとして自己表現しています。AWS、GCP、Azure、および OCI から調達した 400 万件以上のクラウド インスタンスにわたり、20 000 台を超える GPU を同時に稼働させます。 ### 信頼性エンジン - **ブート & ランチ**:Cloud A は最もシンプルな API(約 99.6 % の起動成功率、2–3 分)を提供します。Cloud C の H100 は数か月にわたり過熱(>90 °C)し、Cloud D の A10 は頻繁に HW_SLOWDOWN/POWER_BRAKE イベントが発生しました。Cloud B は最も高いクリティカル エラー率を示します。 - **マシンイメージ**:継続的インテグレーションで各イメージをビルド・テストし、NVIDIA ドライバ 580.95.05 を組み込みます。視覚的ロールアウト ダッシュボードと失敗時の自動ロールバックが備わっています。 - **ブートチェック**:軽量な systemctl、nvidia‑smi、および基本的な GPU 読み書きでハードウェアを検証し、自動スケーリングを遅延させません(Cloud C の L4 は CUDA 初期化失敗 ≈0.1 %)。 - **パッシブヘルスチェック**:dcgmi/dmesg が Xid エラー、ECC 失敗、および熱違反(>88 °C)を監視します。 - **アクティブヘルスチェック**:毎週診断で GPU をロックし、DCGM diag レベル 2、GPUBurn、NCCL all‑reduce、および計画的な InfiniBand テストを実行。失敗は隔離または廃棄のトリガーとなります。 ### 観測性とサポート 観測ダッシュボードはメモリ、利用率、温度、コンテナごとの電力を表示し、GPU ヘルス イベント(例:Xid 13)はコンテナログに記録されます。Slack ベースのプライベート チャネルがエンタープライズ SLA を提供し、コミュニティ サポートは検知されなかった GPU 故障に対してクレジット払い戻しを行います。 ### パフォーマンスベンチマーク ベンチマークテストでは、SXM H100 が PCIe H100 より約 40 % 高い torch_matmul 時間短縮と FLOPs の増加、および優れたメモリ帯域幅を示します。 ### 成果とポジショニング Modal は GPU アップタイムを「4 nines」(99.999 %)程度であると主張し、GPU が CPU より信頼性が低いこと(Meta の報告では LLaMA 3 トレーニング時に 58.7 % の GPU 問題)が認識されています。同社は顧客向けの専任 GPU 信頼性チームとして自社を位置づけ、「単独で進む」ことへの警告を発しています。 Modal のアプローチがスケールすれば、企業は GPU ダウンタイムを大幅に削減し、トレーニングスループットを向上させる可能性があります。これはハイパースケーラーが GPU サービスを設計する際の考慮事項に影響を与えるかもしれません。

**Show HN:** *ゼロから作るテキスト‑ツー‑ビデオモデル* (兄弟二人、開発期間2年、パラメータ数20億)

## Japanese Translation: 現在の要約は明確で正確であり、曖昧な表現がありません。そのまま繰り返すことができます。

**デザイン思考関連書籍(2024年)**

## Japanese Translation: --- ## Summary この記事では、デザイン思考がしばしば「創造性のための簡単な5段階レシピ」と誤解されることを指摘しています。代わりに、実践はIDEAやIDEOの人気モデルのような硬直したプロセスに頼るよりも、問題フレーミング、人間中心設計、ヒューリスティクスといった堅固な理論に基づくべきだと強調しています。 コアテキストの更新版参考文献が提示されており、新たに *The Science of Artificial*(Herbert Simon)と「Wicked Problems in Design Thinking」(Richard Buchanan)が追加されています。古典的タイトルとしては、*Design Expertise*、*Frame Innovation*、*How Designers Think?*、*Change by Design*、そして *The Design of Everyday Things* が挙げられます。これらの作品は、手順を押し付ける方法論ではなく、コア原則を教えています。 記事はIDEOモデルの指示的性質を批判し、プロトタイピング、ストーリーテリング、インクルーシブデザインといったツールを効果的に適用するには、それらの背後にある理論を理解する必要があると指摘しています。また、Gilbert Cockton の新しい語彙提案「Axiofact = A_tefact + Memoranda」を紹介し、線形段階ではなく同時進行の「エピソード」に置き換えることでワイキッド問題をよりよく扱う方法を示しています。 Rittel & Webber による「ワイキッド対テイルド問題」の区別が述べられ、ワイキッド問題は不明確で完全に解決されることがなく、反復的な洗練を必要とすると指摘されています。記事は読者にコメント欄で追加の本推奨を共有するよう促し、ダブルダイヤモンド、インパクト測定、そしてデザイン思考が常に機能しない理由についての関連ディスカッションへのリンクも提供しています。 **主なポイント:** 簡単なステップバイステップアプローチから、より深い理論的理解へ焦点を移すことで、実務家・企業・教育者が複雑またはワイキッドなデザイン課題に対処するための、より洗練された問題指向メソッドを採用できるようになる。

**3Dプリンティングの一年間**

## Japanese Translation: (すべての重要ポイントを含む)** Bambu A1 Miniは、ロンドンの小さなアパートに最適なコンパクト(£149)の3‑Dプリンターです。2025年に著者は、フック、マウント、収納ボックス、ケーブルラップ、机下引き出し、Apple Watchスタンド、ノートパソコンスタンド、磁石付き自転車ヘルメットフック、および耐久性のあるPETG製自転車用水筒キャリー(≈ £0.50)など、実用的な家庭用品を幅広く印刷しました。他のプロジェクトでは、カスタムOrtliebパニアバイカラーリプレイスメント、IKEA RÅSKOGトロッカーシェルフをNotSureとd4v3igインサートでアップグレードしたもの、テトリス風バランスゲーム、AirPodケース、Touch Mapperによる3Dマップ、UNOカードボックスのようなボードゲームオーガナイザーが紹介されました。 プリンターには組み込みベッドレベリングとフロー率校正機能があり、ユーザーフレンドリーです。フィラメントは1kgあたり£10–15(装飾用/室内部品用のPLA、耐熱・耐久性のあるパーツ用のPETG)。設計リソースは主にPrintablesとMakerworldから取得し、必要に応じてブラウザベースのOnShapeやFusion 360でカスタムモデルを作成します。Gridfinityモジュラーシステムは中毒性があると強調され、個別インサートを作成するためにGridfinity GeneratorとTooltraceが推奨されています。 全体として、この記事は家庭の問題を迅速に解決したい人々に3‑Dプリンターを入手することを勧めています。手頃で実用的な印刷が廃棄物を減らし、商業製品を置き換え、趣味家や小規模ビジネスにローカライズされた持続可能な製造へとインスピレーションを与えることを強調しています。

ステータス/ニード・トリアージ ラベルが削除されたようです。

## Japanese Translation: Gemini のコマンドラインインターフェース(CLI)は、JetBrains IDE をネイティブに認識できるようになりました。これには、JetBrains ターミナルセッションを示す特定の環境変数をチェックする仕組みが追加されています。以前は CLI は VS Code スタイルの端末(`TERM_PROGRAM=vscode`)しか検出せず、ファイルベースのポート検出に頼っていたため、Windows や Linux で失敗し、ユーザーは VS Code 設定を偽装する必要がありました。 このプルリクエストでは、JetBrains 系列全体(IntelliJ、PyCharm 等)の `IDE_DEFINITIONS` エントリを追加し、さらに `TERMINAL_EMULATOR=JetBrains‑JediTerm` を明示的に認識するようにしました。この変更は、オープンソースの問題 (#9273 と #16083) によって検出失敗が指摘されたことから推進されました。結果として、Gemini CLI は環境変数を通じて JetBrains IDE を自動的に検出・接続できるようになり、ポートファイルに頼らずに信頼性の高いクロスプラットフォーム統合が実現し、回避策の必要がなくなりました。

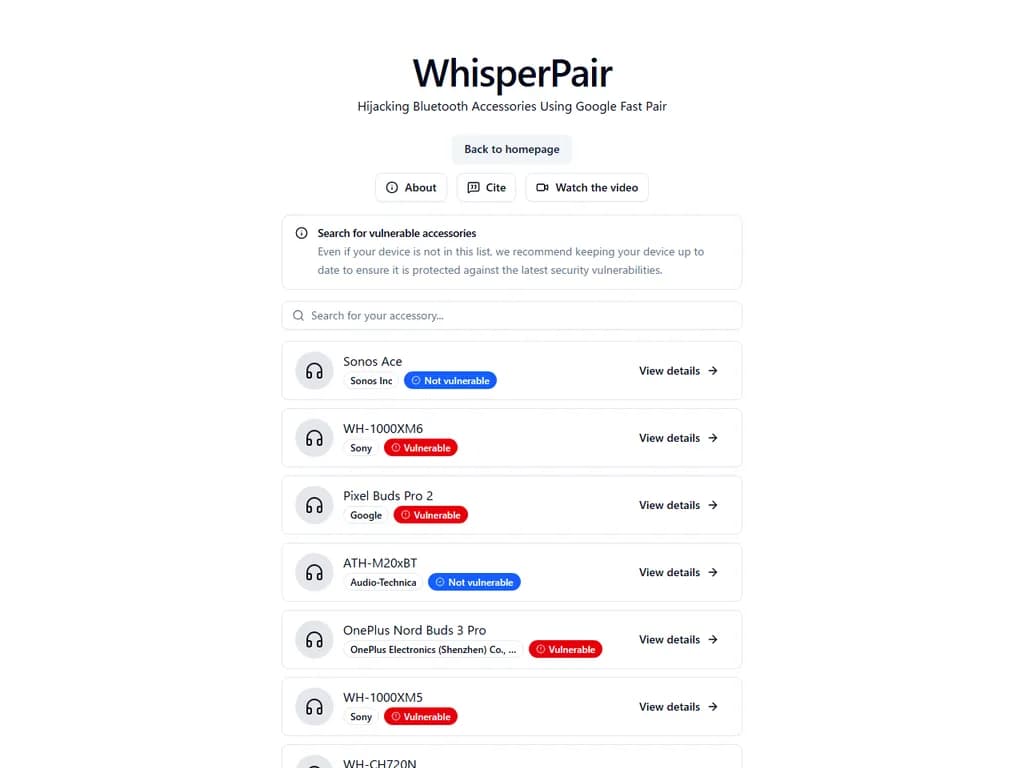

**脆弱なWhisperPairデバイス – ファストペアでBluetoothアクセサリをハイジャックする**

## Japanese Translation: ## 要約 この記事では、OnePlus Nord Buds 3 Pro や Nothing Ear (a) など脆弱性が知られている Bluetooth デバイスと、ATH‑M20xBT Audio‑Technica、Bose QC Ultra Headphones、Beosound A1 2nd Gen、および Beats Solo Buds のように脆弱性リストに載っていないデバイスを列挙しています。モデルが脆弱性リストに含まれていなくても、すべてのデバイスを更新し続けることをユーザーに推奨しています。WhisperPair テストハーネスは、悪用される可能性への倫理的懸念から非公開とされています。自分のデバイスをテストしたいユーザーはプロバイダーへ連絡してアクセスをリクエストできますが、それ以外の場合は製造元のファームウェア更新を待つ必要があります。

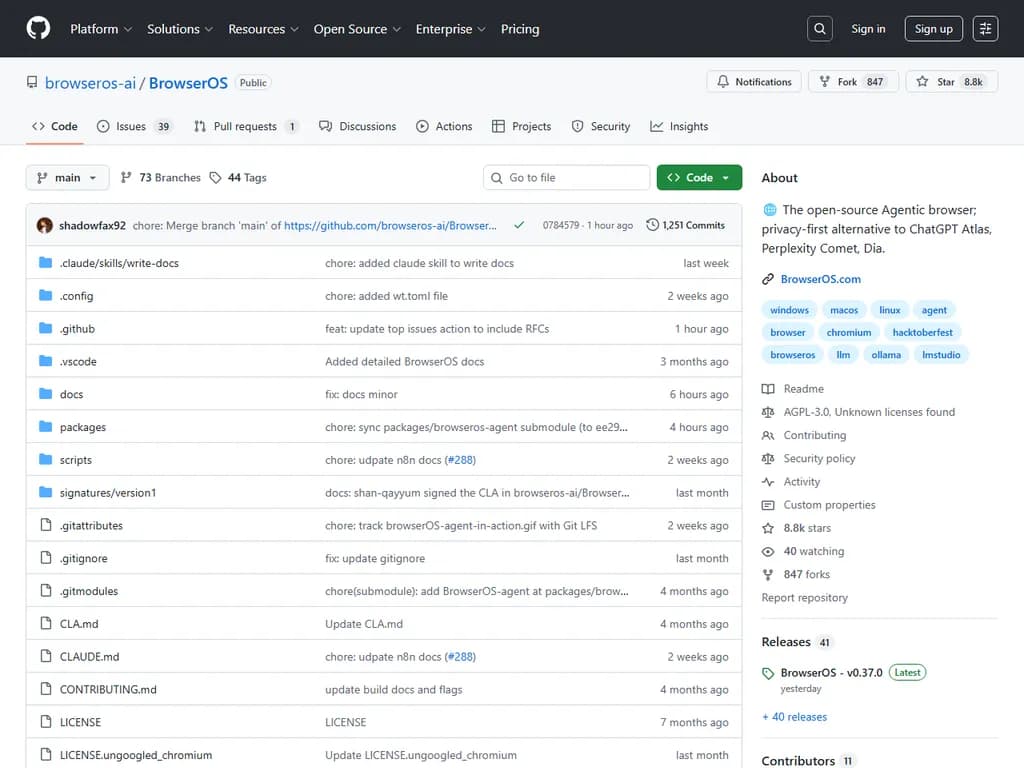

**Show HN:** BrowserOS – “Claude Cowork” in the browser → **Show HN:BrowserOS ― ブラウザで動く「Claude Cowork」**

## Japanese Translation: > **BrowserOS** は、ユーザーがブラウザ内で直接AIエージェントを実行できる無料のオープンソースChromium派生版です。すべてのデータをローカルに保持することで最大限のプライバシーを確保します。ChatGPT AtlasやPerplexity Cometといった商用ツールとは異なり、BrowserOSはAIエージェントをネイティブにサポートし、OllamaまたはLMStudioを介してローカルホスト型モデルを使用できるため、クラウドベースのデータが第三者サービスへ送信されることはありません。 > > インターフェイスはGoogle Chromeを模倣していますが、AI駆動の広告ブロッカーや完全な拡張機能互換性といった機能も追加しており、ユーザーのプライバシーを尊重したドロップイン置き換えとして機能します。macOS、Windows、Linux(AppImage)、Debianにインストールでき、MCPサーバーとして動作し、claude‑codeやgemini‑cliなどのツールから制御可能です。 > > BrowserOSはSan Francisco発のコミュニティ主導プロジェクトであり、バグ報告、機能アイデア、DiscordまたはTwitterを通じた貢献が歓迎されています。AGPL‑3.0ライセンスにより、開発者はチャット、データスクレイピング、タスク自動化のための新しいAIエージェントでプラットフォームを拡張できます。簡潔に言えば、BrowserOSはAIを直接ブラウザに統合したプライバシー優先型閲覧体験を提供し、Chrome(AIなし)、Brave(多機能重視)、Arc/Dia(クローズドソース)、Perplexity Comet、およびChatGPT Atlasと対抗しています。

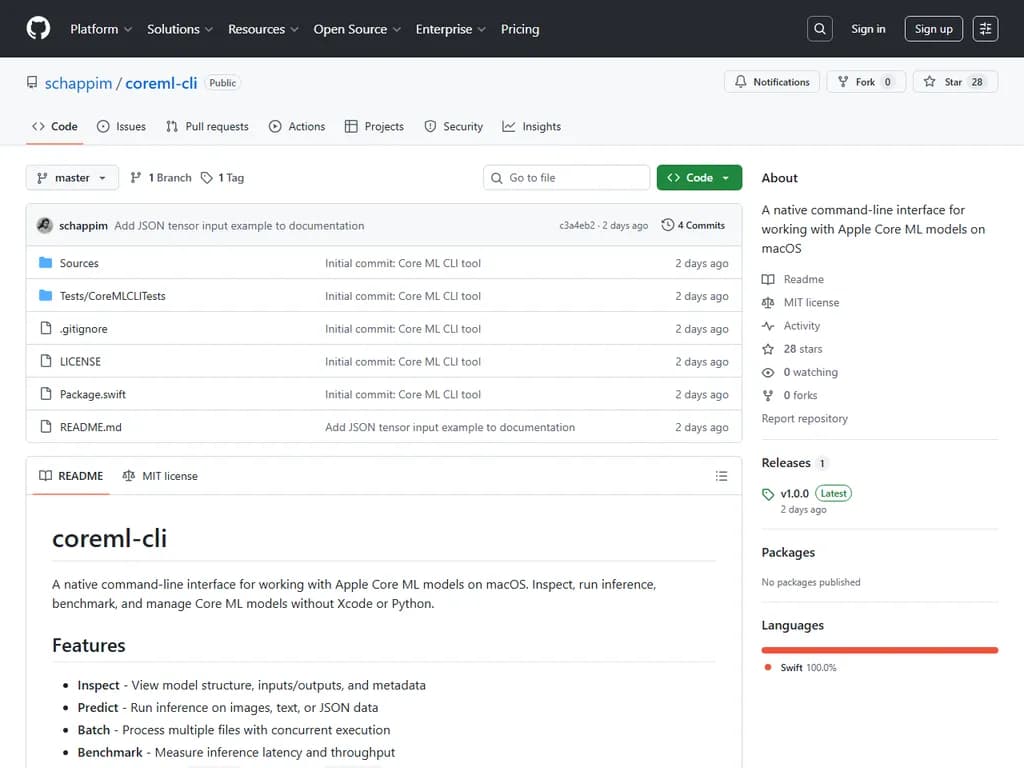

Show HN:Apple Core ML モデルを扱うためのCLI (Note: "Show HN" is a Hacker News title format; translated as 「Show HN」.)

## Japanese Translation: ``` ## Summary `coreml-cli` は、Xcode や Python スクリプトを使用せずに Apple Core ML モデルの検査・実行・ベンチマーク・コンパイル・メタデータ取得を可能にするネイティブ macOS コマンドラインツールです。 ### Core commands | Command | Purpose | |---------|---------| | `inspect` | モデルアーキテクチャとレイヤ詳細を表示 | | `predict` | 画像、音声、テキストまたはテンソル入力に対して単一推論を実行 | | `batch` | ディレクトリ内の多数入力を分類(csv/json 出力対応) | | `benchmark` | レイテンシとスループットを測定;平均/最小/最大/標準偏差/パーセンタイルを出力 | | `compile` | `.mlmodel` を最適化された `.mlmodelc` に変換;オプションで `--validate` | | `meta get` | モデルメタデータ(作者、説明、ライセンス、バージョン)取得 | ### Global flags - `--json / -j` – JSON 出力(CI/CD に便利)。 - `--device <cpu|gpu|ane|all>` – 実行ハードウェアを指定。 - `--help / -h`, `--version` – 標準 CLI ヘルプとバージョン情報。 ### Supported input types - **Images**: `.jpg`, `.jpeg`, `.png`, `.heic` - **Audio**: `.wav` - **Text**: `.txt` - **Tensors**: `.json` ### Installation - Homebrew: `brew tap schappim/coreml-cli && brew install coreml-cli` - GitHub Releases: macOS 用バイナリをダウンロード。 - From source (macOS 13+ with Swift 5.9+): リポジトリをクローンし、`swift build -c release` を実行。 ### Example usage ```bash # Inspect a model coreml inspect MobileNetV2.mlmodel # Run inference on GPU coreml predict MobileNetV2.mlmodel --input photo.jpg --device gpu # Batch classify with CSV output coreml batch MobileNetV2.mlmodel --dir ./photos --out ./results --format csv # Benchmark and get JSON for CI coreml benchmark MobileNetV2.mlmodel --json > bench.json # Compile for deployment coreml compile MobileNetV2.mlmodel --validate --output MobileNetV2c # Get metadata coreml meta get MobileNetV2.mlmodel ``` ### Impact `coreml-cli` は、CPU、GPU、または Apple Neural Engine を直接ターミナルから使用して Core ML モデルを迅速にネイティブテストできるようにします。これによりデプロイサイクルが高速化され、Xcode 中心のワークフローへの依存が減少し、開発者・データサイエンティストおよび CI/CD パイプラインはモデル性能と品質を自動的に検証できます。 ```

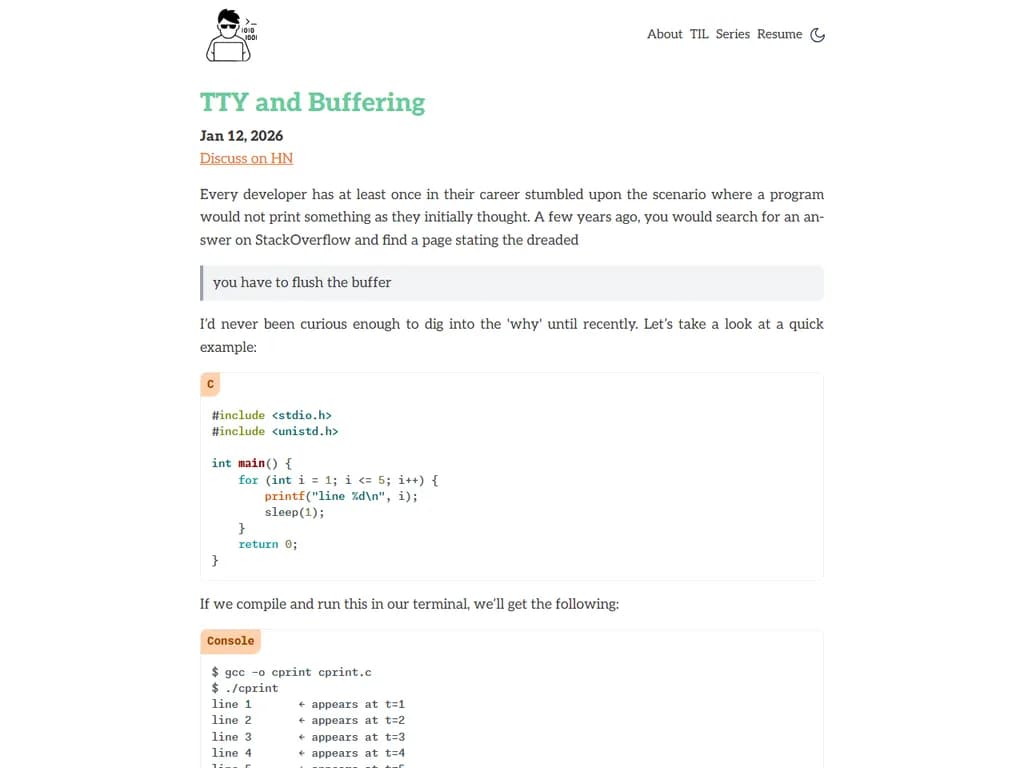

**TTYとバッファリング**

## Japanese Translation: Rust の標準出力は、C と異なり常に **行バッファリング** を使用するため、出力がパイプで接続されたりリダイレクトされた場合でも同様です。対照的に C プログラムは端末外ではブロック(フル)バッファリングに切り替わるため、数キロバイト分のデータが蓄積してから表示されることがあり、パイプラインで顕著な遅延を引き起こします。Rust の `print!` マクロは `LineWriter` を通じて書き込みを行い、環境に関係なく各行が即座にフラッシュされます。開発者が明示的に制御したい場合は、`io::stdout().flush()` を呼び出して出力を強制的にフラッシュできます。 標準ライブラリでは現在 `Stdout` が **FIXME** コメント付きで実装されており、標準出力が端末に接続されているかどうか(`IsTerminal::is_terminal()`)に応じて `LineWriter` と `BufWriter` のどちらを選択するべきだと示されています。Ripgrep などのツールはすでに TTY 検出を利用して色付けやバッファリングを切り替えており、対話型端末には行バッファリング付き出力を、非TTY環境にはブロックバッファリング付き出力を選択します。 Rust の `Stdout` が常に行バッファリングをデフォルトとするため、Rust プログラムはコマンドラインセッションと自動化ワークフローの両方で一貫した予測可能な出力を示します。これにより、パイプやリダイレクト時に C のフルバッファリングが引き起こす遅延や不意な挙動と比べてデバッグが簡素化され、驚きが減少します。