2025/12/23 0:38

**大型コードベースへのLLMスケーリング**

RSS: https://news.ycombinator.com/rss

要約▶

Japanese Translation:

記事は「ワンショット(one‑shot)」― 大規模言語モデル(LLM)に単一の試行で高品質なコードを生成させること―が最も効率的なプログラミング手法だと主張していますが、これはスマートなプロンプト設計、整頓されたコードベース、人間による監督に依存します。既存のコードを書き直すより新規にコードを書く方が時間がかかることが多いと説明し、したがってプロンプトはモデルが詳細な設計決定を推論できるよう、特定のビジネスニーズを分離して提示するべきだと言います。最新のプロンプトライブラリを維持すると失敗を早期に検出できますが、プロジェクト内の技術的負債は自動化を妨げます。エンジニアはタスクに合ったLLMバリアントを評価し、抽象化ルールをプログラム的フィードバックで強制する安全チェックを適用する必要があります。本稿ではMetaが技術負債のため自動化に苦労した事例と、人間とモデルの両方を支援するCursorのモジュラーコーディング実践を対比しています。将来的な取り組みとしては、プロンプトライブラリの洗練、品質保証への障壁低減、テストの簡素化、プルリクエストフィードバックをドキュメントに埋め込むことで増大する検証要求を管理することが挙げられます。設計スキル(書籍・ブログ読解、傑作模写、問題分解の実践)に投資し、クリーンなコードベースを保ち、監督体制を整備した企業はより速く信頼性の高いLLM生成コードを生み出せるため、業界が標準化されたプロンプトと安全プロトコルへ進むリーダーとなり得ます。

本文

LLMを大規模コードベースにスケールさせるには?

現時点で誰も正確な答えを持っていません。

しかし、LLMがエンジニアリングにどのように貢献するかを理解すれば、ガイダンスと監督への投資は十分価値があることがわかります。

ガイダンス:文脈・環境

監督:実装者の選択を導き、検証し、確認するために必要なスキルセット

ガイダンスへの投資

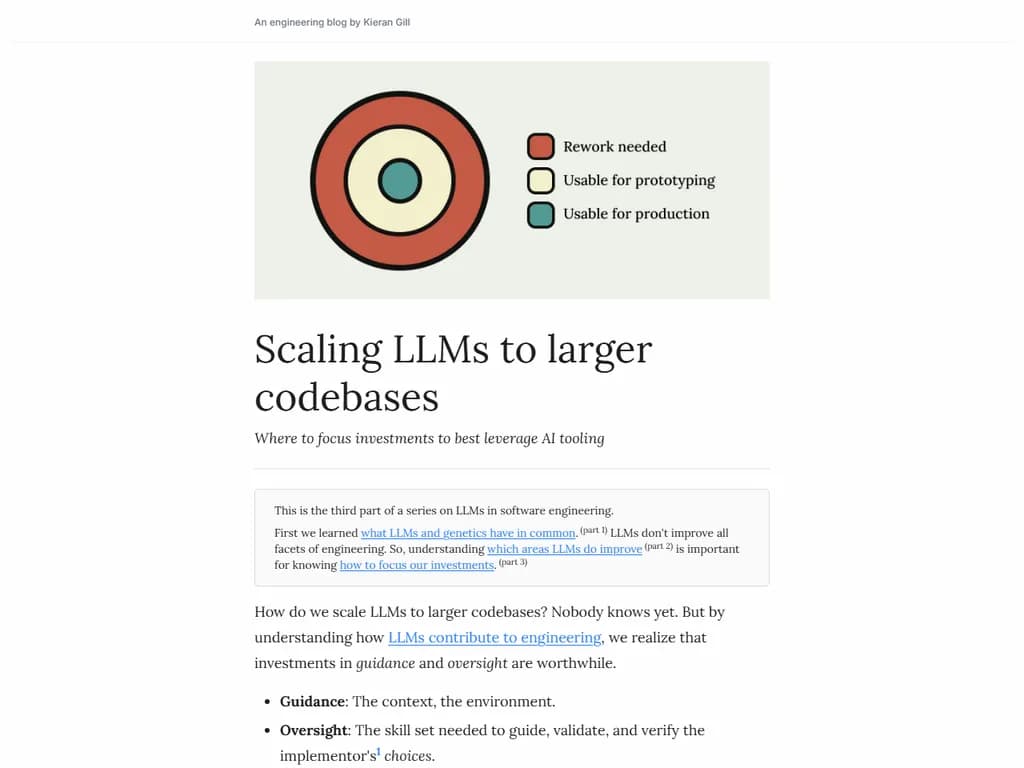

LLM が一度で高品質な実装を生成できる状態は ワンショット と呼ばれます。

これは LLM プログラミングの最も効率的な形態です。

対照的に、リワーク とは、使用可能な出力が得られず手動で介入しなければならないケースを指します。

リワークは自分で作業するより時間がかかることが多いです。

では、ワンショットの機会を増やすにはどうすればよいでしょう?

より良いガイダンスです。

より良いガイダンス

LLM は「選択生成器」です。トークン一つひとつがコードベースに追加される選択です:

- 変数名の付け方

- 関数の構成

- 再利用 vs. 重複機能

- 技術選定(Postgres か Redis かなど)

多くの場合、これらの選択はデザイナー(例:プロンプト)に委ねられますが、すべてを網羅的に列挙したり、間違いがあればリワークするのは非効率です。

理想的には、プロンプトは機能要件だけを捉え、残りの選択は推論可能かエンコード済みであるべきです。

プロンプトライブラリを書こう

プロンプトライブラリ は LLM の文脈として組み込めるドキュメントです。

次を集約して作成します:

- ドキュメント

- ベストプラクティス

- コードベース全体の一般的なマップ

- 生産性に必要なその他のコンテキスト

ライブラリは反復で有効化します:LLM がややズレた場合、「何を明確にすべきだったか?」と尋ね、その答えを再度ライブラリへ追加します。網羅性と軽量さのバランスが重要です。

環境=文脈

Meta の経験では、技術的負債でいっぱいのコードベースは自動化を妨げます。

対照的に Cursor チームは「繰り返しなし」「シンプルさ」「洗練された構造」といったクリーンソフトウェア原則を重視しています。これは「ゴミ入力はゴミ出力」に直結します:悪い入力は誤情報(hallucination)につながります。

LLMリテラシーの簡易チェック

- ヒューマンドップステッキ – 未知コードを同僚エンジニアに読ませます。もし彼らが苦労すれば、LLM もそうでしょう。

- LLMDipstick – LLM エージェントに特定機能の動作を尋ねます。既に答えが分かっていないなら、LLM も知らないはずです。

LLM の検索行動(grep, ls, cat 等)を記録し、各プロンプトでコードベースを再発見しないようマップを提供します。マップが取れない場合は、モジュラリティ、命名の一貫性、カプセル化されたロジックなどでナビゲーションを簡素化し、これらの慣習をプロンプトライブラリにエンコードします。

監督への投資

ガイダンス と 監督は不可欠です。中学生が運転する3トン車の例で、適切な監督なしにエンジニアリングを自動化すると危険だと示しています。チームを破棄するのではなく育成すべきです。

エンジニアは「即時実装」と「将来のコードベース健康」という二つのタイムラインで働きます。監督者は、LLM の選択(例:Redis か Postgres か)が妥当だったかを判断しなければなりません。

監督を投資として捉える

- チーム – 読書・実践・模倣で設計能力を向上させる。

- 整合性とワークフロー – オペレーターは技術的知識だけでなくプロダクトの専門知識も必要です。深いプロダクト理解がなければ、誤ったソリューションを構築してしまいます。

監督の自動化

設計上の懸念事項はプログラムでチェックできます:

- 安全性チェック – 抽象化(例:配列境界)を保護。

- 検証ツール – ビジネスロジックとアーキテクチャロジック両方のテスト。

検証ボトルネックへの対処

- 手動 QA のハードルを下げる(開発環境不要)。

- テスト設定に投資し、最小限のコードでテストやテストデータ作成が容易になるようにする。

- PR フィードバック頻度をドキュメント化しておけば、LLM が妥当なレビューを実行できます。

- フレームワーク内にセキュリティの既定値を組み込み、文脈だけではなく実装に落とし込む。

以上です。

これは LLM をソフトウェアエンジニアリングに適用するシリーズの第3部でした:

- LLM と遺伝学の共通点

- LLM が特定領域をどのように改善するか

- (現在)ガイダンスと監督への投資