2025/12/10 1:37

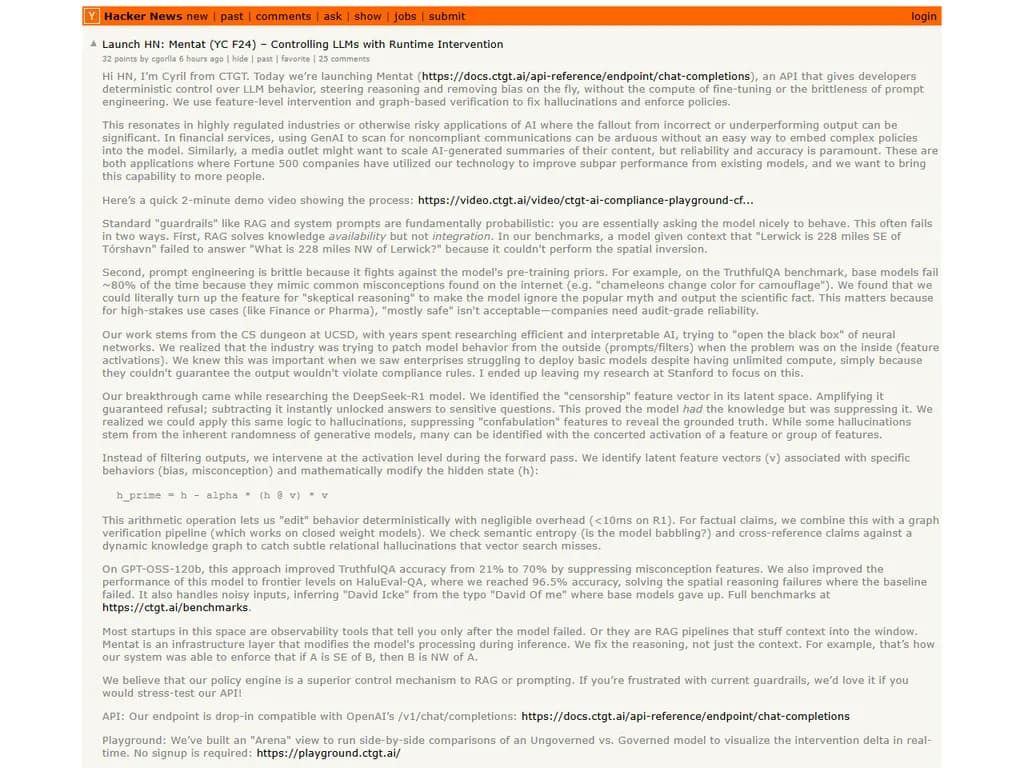

Launch HN: Mentat (YC F24) – Controlling LLMs with Runtime Intervention

RSS: https://news.ycombinator.com/rss

要約▶

Japanese Translation:

Mentatは、ファインチューニングや複雑なプロンプトエンジニアリングを必要とせずに、開発者が大規模言語モデル(LLM)を決定論的かつ機能レベルで制御できる新しいAPIです。推論時に次の式を使用して介入します。

h' = h – α · (h @ v) v

ここで、vは「検閲」ベクトルと呼ばれる潜在変数で、増幅すると拒否を強制したり、減算すると回答を解放したりします。この操作はDeepSeek‑R1上で10 ms未満で実行されます。

Mentatのグラフベース検証パイプラインは、セマンティックエントロピーと動的知識グラフに対するクロスリファレンスをチェックし、単純なベクトル検索では見逃されがちな微妙な関係性の幻覚を検出します。ベンチマークでは劇的な向上が確認されています:TruthfulQAでGPT‑OSS‑120bの精度は21 %から70 %に、HaluEval‑QAは96.5 %に達し、「David Of me」→「David Icke」のような問題を解決しました。

このシステムはインフラ層として提示され、OpenAI互換エンドポイント(/v1/chat/completions)が即座に利用できるほか、開発者が統治モデルと非統治モデルを横並びで比較できる「Arena」プレイグラウンドも提供します。チームはUCSDの研究者と元スタンフォード教授から構成されており、効率的で解釈可能なAIとニューラルネットワークにおける制御可能な潜在特徴の発見を先駆けてきました。

Mentatは、誤った出力が重大な結果を招く金融・製薬・メディアなどの規制産業に属するフォーチュン500企業向けにマーケティングされています。開発者はAPIのストレステストに参加でき、会社はリアルタイムフィードバックチャネルと毎日のバグハンティングサポートを提供しています。完全なベンチマーク結果は https://ctgt.ai/benchmarks で確認できます。

本文

こんにちは、HNさん

CTGTのCyrilです。今日は Mentat(https://docs.ctgt.ai/api-reference/endpoint/chat-completions)を公開しました。このAPIは開発者にLLMの振る舞いを決定的に制御する手段を提供します。推論の途中で思考過程を誘導し、バイアスを除去できるため、ファインチューニングの計算コストやプロンプトエンジニアリングの脆弱性を伴いません。

特徴レベルの介入とグラフベースの検証を組み合わせて以下を実現します。

- ハルシネーションの修正

- ポリシーの強制

これらは、誤った出力や性能低下が重大になる高規制業界やリスクの高いAIアプリケーションで特に有効です。金融サービスでは、GenAIを使って非準拠コミュニケーションをスキャンする際、複雑なポリシーをモデルに埋め込む簡易手段がないと大変です。同様にメディア社はコンテンツのAI生成要約をスケールしたいものの、信頼性と正確さが最優先されます。

フォーチュン500企業も既存モデルの性能低下を改善するために当社技術を採用しており、この機能をより多くの人へ届けたいと考えています。

デモ動画(2 分):

https://video.ctgt.ai/video/ctgt-ai-compliance-playground-cf…

1. 標準的なガードレールが失敗する理由

-

RAG は知識の可用性を解決しますが、統合はできません。

例: 「LerwickはTórshavnから南東228マイルに位置する」という文脈を与えても、「Lerwickから北西228マイルにある場所は?」と問われると空間的反転が行えず答えられません。 -

プロンプトエンジニアリング はモデルの事前学習先入観と対立するため脆弱です。

例: TruthfulQAでベースモデルは「カメレオンは色を変えてカモフラージュする」という誤解に80 %近く当たってしまいます。私たちは「懐疑的推論」機能を有効化し、神話を無視して科学事実を出力させることができます。

高リスクケース(金融・製薬)では「ほぼ安全」で十分とは言えません。企業は監査レベルの信頼性を必要とします。

2. 私たちのアプローチ

-

フォワードパス中の特徴レベル介入

特定行動(バイアス、誤解)に関連する潜在ベクトル (v) を検出し、隠れ状態を次のように修正します。[ h' = h - \alpha ,(h @ v), v ]

この決定的な編集はオーバーヘッドがほぼゼロ(R1で10 ms未満)です。

-

事実主張のグラフ検証パイプライン

セマンティックエントロピー(モデルが無意味に語っていないか)を確認し、動的知識グラフと照合してベクトル検索では見逃される微妙な関係性ハルシネーションを検出します。

GPT‑OSS‑120b での結果は以下の通りです。

| メトリクス | ベースライン | Mentat使用時 |

|---|---|---|

| TruthfulQA 正確度 | 21 % | 70 % |

| HaluEval‑QA 正確度 | – | 96.5 % |

また、ノイズの多い入力(例:「David Icke」を「David Of me」と誤記した場合)でもベースモデルが諦めるところを解決します。

完全なベンチマークは https://ctgt.ai/benchmarks でご覧いただけます。

3. 提供内容

- API エンドポイント:OpenAI の

とドロップイン互換/v1/chat/completions

https://docs.ctgt.ai/api-reference/endpoint/chat-completions - Playground(Arena):非ガバナンスモデルとガバナンスモデルを並べて比較し、介入差分をリアルタイムで可視化

https://playground.ctgt.ai/

ご意見や標準モデルが失敗するエッジケースをぜひ教えてください。コメント欄で一日中待機しています—どんなフィードバックも歓迎です!