2025/11/30 20:36

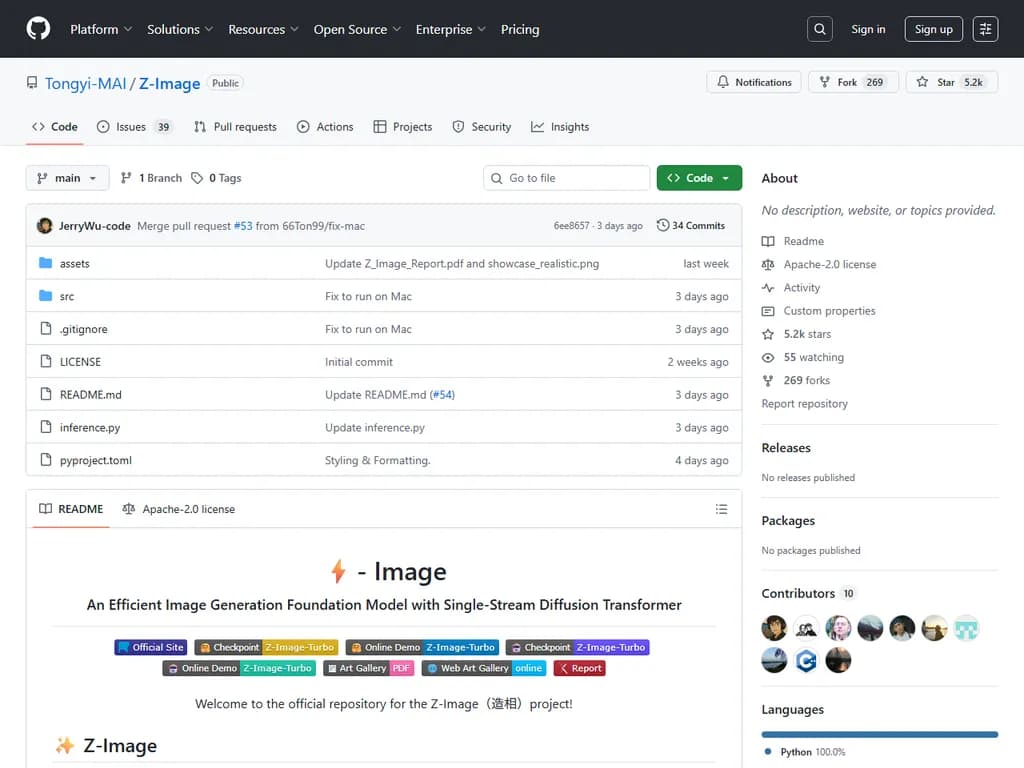

Z-Image: Powerful and highly efficient image generation model with 6B parameters

RSS: https://news.ycombinator.com/rss

要約▶

Japanese Translation:

概要:

アリババの新しいZ‑Imageファミリーは、6 Bパラメータを持つ画像生成モデルで、Turbo、Base、Edit の3種類がリリースされています。

• Z‑Image‑Turbo は ≤8 Neural Function Evaluations (NFEs) に蒸留されており、16 GB 未満のVRAMを搭載した H800 GPU 上でサブセカンド推論が可能です。フォトリアリズム、英語と中国語の二言語テキストレンダリング、および指示遵守に優れています。

• Base モデルは蒸留されていない基盤チェックポイントで、公開時にはコミュニティによるファインチューニングが可能になります(現在はまだ公開されていません)。

• Edit バリアントは自然言語プロンプトに応じた画像編集タスク用にファインチューニングされており、創造的な画像から画像への変換を実現します。

• アーキテクチャとして、Z‑Image はテキスト・視覚意味トークン・VAE トークンを1つの拡散ストリームに結合する Scalable Single‑Stream DiT (S3‑DiT) をベースにしており、パラメータ効率を最大化しています。

• 性能は Alibaba AI Arena の Elo ベースの Human Preference テストで評価され、Turbo は主要なオープンソースモデルと同等またはそれ以上の結果を示しました。

• 蒸留は 2025 年 arXiv に掲載された Decoupled‑DMD(CFG 増幅と分布マッチングを分離)および DMDR(Decoupled‑DMD と RL を組み合わせて意味整合性と高周波詳細を実現)手法に依存しています。

• コミュニティ向けデプロイツールとしては、Cache‑DiT (DBCache, Context Parallelism, Tensor Parallelism)、LeMiCa(トレーニング不要のタイムステップ加速)、stable‑diffusion.cpp(低VRAM推論用)、および ComfyUI ZImageLatent(潜在空間操作用)が提供されています。

• モデルは Hugging Face と ModelScope で入手可能です:Turbo は既にリリース済み、Base および Edit チェックポイントは後日公開予定です。

• アリババの Z‑Image チームでは現在 Research Scientist、Engineer、および Intern を積極的に採用しています(お問い合わせ先: jingpeng.gp@alibaba-inc.com)。

本文

⚡️ Z‑Image – シングルストリーム拡散トランスフォーマーを採用した高効率画像生成基盤モデル

✨ 概要

Z‑Image は、6 B パラメータを持つ高性能画像生成モデルで、以下の3種類があります。

- Z‑Image‑Turbo – 蒸留済み、8 NFE、H800 GPU でサブセカンドレイテンシ、<16 GB VRAM。フォトリアリスティックかつ双言語テキスト描画が可能。

- Z‑Image‑Base – 蒸留されていない基盤モデル(コミュニティ向けファインチューニング用)。近日公開予定。

- Z‑Image‑Edit – 画像編集に特化してファインチューニング済み。自然言語プロンプトでクリエイティブな画像対画像生成をサポート。

📥 モデルズー

| モデル | Hugging Face | ModelScope |

|---|---|---|

| Z‑Image‑Turbo | ✅ | ❌ |

| Z‑Image‑Base | 近日公開 | 近日公開 |

| Z‑Image‑Edit | 近日公開 | 近日公開 |

🖼️ 実例

- フォトリアリスティック品質 – 優れた美学と高い写実性を実現。

- 正確な双言語テキスト描画 – 複雑な中国語・英語文字を精密にレンダリング。

- プロンプト強化 & 推論 – Prompt Enhancer が推論の理解力を向上させます。

- クリエイティブ画像編集 – バイリンガルの編集指示と柔軟な変換が可能。

🏗️ モデルアーキテクチャ

Z‑Image は Scalable Single‑Stream DiT (S3‑DiT) アーキテクチャを採用。

テキスト、視覚意味トークン、VAE 画像トークンをシーケンスレベルで結合し、単一の入力ストリームとして扱うことで、デュアルストリーム設計よりもパラメータ効率を最大化します。

📈 性能

Alibaba AI Arena の Elo ベース人間好み評価において、Z‑Image‑Turbo は主要モデルと比較して高い競争力を示し、オープンソースモデルの中で新たな最先端を樹立しています。

完全リーダーボードを見る。

🚀 クイックスタート

1️⃣ PyTorch ネイティブ推論

# 仮想環境作成 python -m venv zimage-env source zimage-env/bin/activate # 依存パッケージインストール pip install torch==2.5.0+cu118 torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

2️⃣ Diffusers 推論

Z‑Image をサポートする最新版

diffuserspip install git+https://github.com/huggingface/diffusers

サンプルコード

import torch from diffusers import ZImagePipeline # パイプライン読み込み pipe = ZImagePipeline.from_pretrained( "Tongyi-MAI/Z-Image-Turbo", torch_dtype=torch.bfloat16, low_cpu_mem_usage=False, ) pipe.to("cuda") # (任意)Flash Attention を有効化(サポートされていれば) # pipe.transformer.set_attention_backend("flash") # Flash‑Attention‑2 # pipe.transformer.set_attention_backend("_flash_3") # Flash‑Attention‑3 # (任意)高速推論のためにモデルをコンパイル(初回は遅くなる) # pipe.transformer.compile() # (任意)CPU オフロードで GPU メモリ節約 # pipe.enable_model_cpu_offload() prompt = ( "Young Chinese woman in red Hanfu, intricate embroidery. " "Impeccable makeup, red floral forehead pattern. Elaborate high bun, " "golden phoenix headdress, red flowers, beads. Holds round folding fan " "with lady, trees, bird. Neon lightning‑bolt lamp (⚡️), bright yellow glow, " "above extended left palm. Soft‑lit outdoor night background, silhouetted " "tiered pagoda (西安大雁塔), blurred colorful distant lights." ) image = pipe( prompt=prompt, height=1024, width=1024, num_inference_steps=9, # 8 DiT フォワードに相当 guidance_scale=0.0, # Turbo モデルはガイダンス 0 を使用 generator=torch.Generator("cuda").manual_seed(42), ).images[0] image.save("example.png")

🔬 Decoupled‑DMD – Z‑Image の加速の秘訣

- CFG Augmentation (CA) – 蒸留を主導するエンジン。

- Distribution Matching (DM) – 安定性と品質を確保する正則化子。

これらを分離して最適化することで、少数ステップでの生成プロセスが向上します。

🤖 DMDR – DMD と強化学習の融合

蒸留後に RL を組み込むと、以下の相乗効果が得られます。

- RL が DMD の性能を引き出す

- DMD が RL を正則化する

結果として、セマンティック整合性・美的品質・構造的一貫性・高周波詳細の向上が実現します。

🎉 コミュニティ活動

| プロジェクト | 内容 |

|---|---|

| Cache‑DiT | Z‑Image の推論高速化(DBCache、コンテキスト並列化、テンソル並列化)。 |

| stable‑diffusion.cpp | CUDA/Vulkan で動作し、4 GB VRAM でも動く純粋 C++ 推論エンジン。 |

| LeMiCa | Z‑Image の学習不要タイムステップレベル高速化。 |

| ComfyUI ZImageLatent | Z‑Image 標準解像度に対応した簡易ラテントインターフェース。 |

📜 引用

ご利用いただく際は、以下の論文を引用してください。

@article{team2025zimage, title={Z-Image: An Efficient Image Generation Foundation Model with Single-Stream Diffusion Transformer}, author={Z-Image Team}, journal={arXiv preprint arXiv:2511.22699}, year={2025} } @article{liu2025decoupled, title={Decoupled DMD: CFG Augmentation as the Spear, Distribution Matching as the Shield}, author={Dongyang Liu and Peng Gao and David Liu and Ruoyi Du and Zhen Li and Qilong Wu and Xin Jin and Sihan Cao and Shifeng Zhang and Hongsheng Li and Steven Hoi}, journal={arXiv preprint arXiv:2511.22677}, year={2025} } @article{jiang2025distribution, title={Distribution Matching Distillation Meets Reinforcement Learning}, author={Jiang, Dengyang and Liu, Dongyang and Wang, Zanyi and Wu, Qilong and Jin, Xin and Liu, David and Li, Zhen and Wang, Mengmeng and Gao, Peng and Yang, Harry}, journal={arXiv preprint arXiv:2511.13649}, year={2025} }

🤝 採用情報

基盤生成モデルとその応用に携わる研究科学者、エンジニア、インターンを積極的に募集しています。

ご興味のある方は jingpeng.gp@alibaba-inc.com までご連絡ください。