2026/01/11 8:46

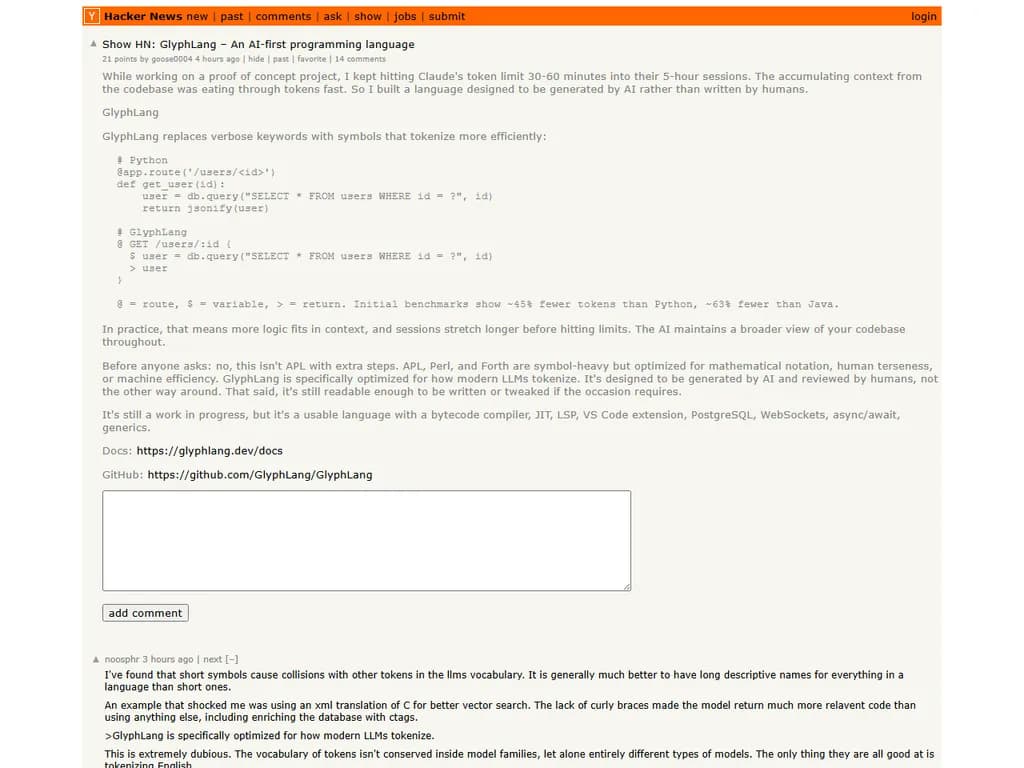

**Show HN:** *GlyphLang – AIファーストのプログラミング言語*

RSS: https://news.ycombinator.com/rss

要約▶

Japanese Translation:

改訂版要約

記事は、トークン数を大規模言語モデル(LLM)のプロンプト設計において主要な焦点とすべきではなく、むしろ「理解の忠実度」―モデルが入力をどれだけ正確に理解し利用できるか―がはるかに重要であると主張しています。LLM は既に Python、JavaScript、Markdown、TypeScript、YAML など多くのプログラミング言語を把握しているため、新しい言語用にカスタム構文を追加することはトークンを消費するだけで実質的な価値を増やさない。短い記号(例:

@Perl の句読点中心のスタイルは LLM の理解を妨げる例であり、コンパクトで多くの記号を用いるコードが問題になることを示しています。著者は、ツール呼び出しにおいて JSON から YAML に切り替えることで、特に小規模モデル(Sunil Kumar の経験)ではエントロピー安定性が向上する点を指摘しています。YAML はコメントを保持し、インデントベースの構造と最小限の区切り文字であるため、JSON の厳格なシンタックス―括弧の一致、必須コンマ、エスケープ規則、コメント不可――がもたらすエントロピー崩壊やモデル柔軟性の制限を回避できるからです。

YAML のコメントはモデルにとってデータとして扱われます。例えば

timeout: 30 # generous because API is flaky理解の忠実度をトークン最小化より優先し、Markdown、YAML、Python、JavaScript、TypeScript などの馴染み深くコメントフレンドリーなフォーマットを採用することで、プロンプトエンジニアは作業負担を減らし、LLM 主導ツールの信頼性を向上させ、構造化データ形式に依存する開発者に恩恵をもたらすことができます。

本文

トークン経済と理解忠実度に関する主なポイント

-

トークンは唯一のボトルネックではない。

実際の制約は 理解忠実度 です。LLM はすでに訓練から Python、JavaScript、Markdown、YAML を知っているため、新しい構文を教えるにはプロンプトごとに数百万トークンが必要になります。 -

コンテキストウィンドウ管理が重要。

新しい構文を学ばせるのではなく、LLM が得意とする領域で設計しましょう。 -

完全な英単語(locque)は LLM の訓練に合致。

LLM は英語風構造を深く理解しますが、短い記号は既存トークンと衝突しやすく、意味ノイズを生みます。 -

ツール呼び出しでの YAML vs. JSON

- JSON: 厳密な括弧・必須コンマ・エスケープシーケンス・コメント不可 → エントロピーが低下。

- YAML: インデントで構造化、最小限の区切り文字、コメント保持 → 高いエントロピーと柔軟な推論が可能。

「JSON から YAML に変更したことで生成エントロピーの安定性が大幅に向上しました。」 – Sunil Kumar(Groundlight AI)

-

コメントはデータである。

コメントは LLM が読み取り、行動できるコンテキストを提供し、JSON はそれらを全て捨てます。 -

Perl の凝縮構文は LLM に不向き。

密集した句読点は行ノイズを増やし、トークナイゼーションと衝突します。 -

理想的な LLM フレンドリー構文: Markdown、YAML、および既に習得済みの言語(Python、JavaScript、TypeScript)。

要約

トークン数 を二次的関心事とし、まずは 理解忠実度 を優先してください。モデルがすでに知っているフォーマット(Markdown/YAML)を使用し、コメントでコンテキストを保持しましょう。既存トークンと衝突する短い記号や、変換器の推論を妨げる複雑な凝縮構文は避けてください。